Dans l’article précédent, « Qu’est-ce qu’un Data Hub ? », nous avons vu que le Data hub est une architecture qui permet de centraliser et regrouper les données d’une entreprise dans un référentiel unique, dans le but de gérer et faciliter les échanges de données dans le SI et garantir leur qualité en utilisant des contrôles intégrés en temps réel.

En effet, le Data Hub présente plusieurs avantages vis-à-vis des architectures traditionnelles, il permet d’interconnecter les composants d’un système d’information en demi-flux (une seule connexion par système) ce qui réduit drastiquement le nombre de flux nécessaire pour connecter les applications. De plus, l’interconnexion en demi-flux permet de gagner en maintenance dans le sens ou un changement d’application affectera seulement la connexion de celle-ci avec le data hub et pas toute l’architecture.

De l’autre côté, le Data Hub donne la possibilité d’interconnecter tous les composants du système d’information quel que soit le type d’échange exigé par le composant (synchrone, asynchrone, batch, API …).

Dans cet article, nous allons voir en détails les composants techniques d’un Data Hub, ainsi que les différentes étapes de la mise en place d’un Data Hub. Nous verrons également les bénéfices de Stambia en tant qu’outil d’intégration de données dans la mise en place d’un projet Data Hub.

L’architecture du Data Hub repose sur un système de stockage, généralement une base de données relationnelle. Pour plus de performance, il peut être connecté à un Data Lake afin d’intégrer des données non-relationnelles. Les échanges de données entre le Data Hub et les autres composants du SI sont assurés par Stambia, ainsi que tous les transferts et les traitements des données effectués entre les différents schémas du Data Hub.

La solution d’intégration de données joue un rôle important dans un projet Data Hub, elle doit permettre l’agilité, l’adaptabilité et l’industrialisation des flux de données. Stambia répond aux problématiques rencontrées dans ce type de projet en apportant une grande capacité de connectivité. Elle peut gérer des connexions de différents types et également industrialiser la construction et la mise en place des flux de données à travers les Templates. Ainsi, la délégation des transformations assurée par l’approche ELT permet d’augmenter la performance des extractions et des transformations de données. De plus, avec la fonctionnalité gestion des rejets de Stambia, il est possible de définir les règles techniques et métier pour contrôler la qualité des données du Data Hub et rejeter les données non-conformes.

Comment structurer son Data Hub ?

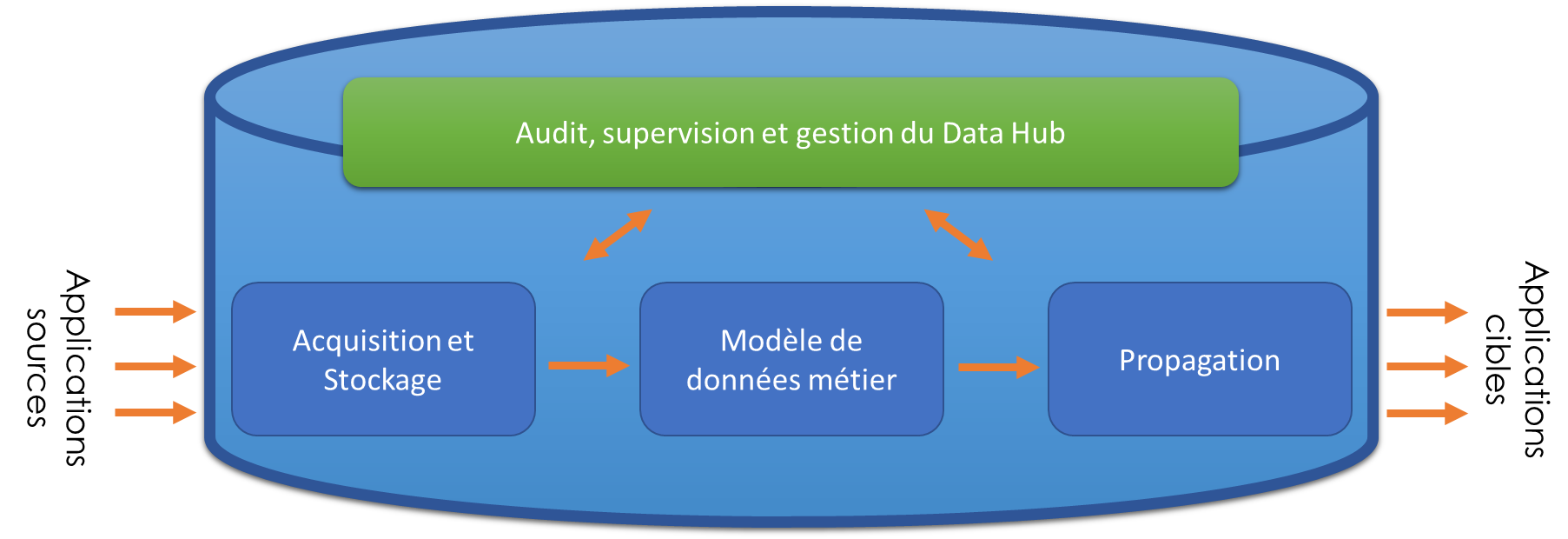

L’architecture d’un Data Hub se compose de quatre éléments essentiels :

- Un espace d’acquisition de données : il est similaire à un ODS, il stockera les données brutes issues des systèmes connectés au Data Hub dans leur format natif.

- Le modèle de données métier : il représente le cœur du Data Hub, selon la structure choisie, le modèle métier peut être composé d’une ou plusieurs schémas de base de données à travers lesquels seront modélisées les données issues des applications sources, ce modèle peut être créé de façon évolutive.

- Un espace de propagation : c’est un schéma de base de données dans laquelle seront préparées les données consommables par les applications cibles. Dans cet espace, une structure de table est créée pour chaque application connectée au Data Hub, elle contient les données à intégrer à cette application au format, à la granularité et au niveau de détail exigé par cette application.

- Couche de supervision et d’audit qui permet de monitorer l’activité du Data Hub, de repérer et traiter les anomalies de données et de gérer la transcodification des données.

Comment mettre en place un Data Hub ?

Pour mettre en place un DH (Data Hub), il va falloir, dans un premier temps, déterminer les applications et les systèmes qui seront connectés au DH. Puis dans un second temps, extraire les données de ces applications et les stocker dans l’espace d’acquisition. Il faudra ensuite créer et alimenter le modèle de données métier tout en mettant en place un processus de contrôle et de synchronisation de données. Puis préparer les données qui seront consommées par les applications cibles dans l’espace de propagation et enfin mettre en place une plateforme d’audit et de gestion du DH. Ce processus sera développé dans la suite de l’article.

Etape 1 : Déterminer les systèmes à connecter

Il est important d’identifier les données qui sont le plus souvent utilisées et qui donnent une vision complète de l’entreprise. L’entreprise doit alors déterminer les systèmes contenant ces données et qui seront en communication avec le DH, ainsi que le type de connexion de chaque système.

Stambia peut apporter une grande agilité dans cette étape. En effet, la capacité de connectivité de Stambia permet de se connecter un grand nombre de technologies et une multitude d’application (ERP, CRM, GPAO, Application métier, Data Lake, …).

À l’issue de cette étape, nous pouvons identifier et caractériser les flux de données servant à alimenter l’espace de stockage.

Etape 2 : Acquisition et stockage de données

Cette étape consiste à extraire les données à partir des systèmes sources pour les entreposer dans l’espace d’acquisition et de stockage. À ce stade, aucune transformation ne sera appliquée aux données, l’objectif est de disposer d’un accès en continu aux données opérationnelles sans nuire à la disponibilité des systèmes en production.

Il est possible d’utiliser le « Template de Réplication » fourni par Stambia pour gagner en performance. Celui-ci permet de répliquer rapidement les données des applications de l’entreprise vers l’espace d’acquisition du DH. Cela peut être effectué à partir des simples paramétrages sans ligne de code ou création de mapping. Il suffit seulement de spécifier les métadonnées de la source et la cible, pour que Stambia gère automatiquement la création des tables et le chargement des données.

Etape 3 : Création du modèle de données métier

Le modèle métier sera utilisé pour stocker les transactions, les faits et les données de référence provenant des systèmes source. Il peut également stocker l’historique des faits et des transactions. Il est possible de modéliser les données des systèmes sources dans une ou plusieurs structures de données et de construire ce modèle de façon progressive.

Dans cette étape, nous allons également créer une structure de données qui stockera des données de gestion et de log pour pouvoir effectuer l’audit et la supervision du DH.

Etape 4 : Alimentation du modèle de données métier

L’alimentation du modèle métier sera faite à l’aide des flux Stambia à partir des données de l’espace d’acquisition. Dans cette étape l’harmonisation sera appliquée sur les données pour standardiser leur format et leur architecture.

Pour contrôler et améliorer la qualité des données transitant via le DH, il est possible d’utiliser le Template de Rejet de Stambia, ce dernier permet de définir des règles techniques ou métier, selon lesquelles les données non-conformes seront rejetées. Ce Template permet également de traiter les données rejetées en appliquant des traitements spécifiques selon le type de rejet et ensuite recycler ces données et les réintégrer dans le DH.

Pour synchroniser les données du modèle métier, Stambia présente plusieurs modes d’échange de données : synchrone, asynchrone, échange en mode batch ou streaming. Le mode de communication peut être choisi selon le composant connecté au DH et selon ses exigences techniques.

Etape 5 : Propagation des données

Cette étape consiste à préparer, pour chaque composant connecté au DH en mode écoute, les données dans le format et la granularité exigée par ce composant. Pour cela, il va falloir créer des tables de propagation spécifiques à chaque composant, ces tables contiendront les données à intégrer ou à mettre à jour.

Pour préparer et synchroniser les données de propagation, Stambia utilise la fonctionnalité CDC « Change Data Capture », qui permet de capturer les modifications apportées aux données et les nouveaux enregistrements.

Etape 6 : Mise en place de la plateforme audit

La plateforme d’audit facilite la gestion du DH et le tracer des informations sur les transformations subies par les données. Les données renseignées dans la structure de données d’audit seront utiles pour monitorer le DH, gérer son fonctionnement et contrôler la qualité des données. Cette plateforme peut être mise en place à l’aide de n’importe quel outil de Repotring.

Quels sont les apports de Stambia dans un projet Data Hub ?

En utilisant Stambia comme outil d’intégration de données, le projet du Data Hub gagne en agilité grâce à des Templates qui permettent d’industrialiser certains développements (Templates de rejet, Templates de réplication).

De plus, la technologie CDC de Stambia, qui consiste à détecter facilement les changements dans les bases de données, permet d’effectuer une intégration de données en temp-réel. Le CDC est utilisé également pour construire le « Delta » de données qui sera propagé à chaque application. Avec le Change Data Capture, Stambia peut synchroniser les données des applications cibles selon la périodicité de synchronisation et le niveau de détail souhaité par cette application.

La mise en place du projet Data Hub avec Stambia peut être abordé par lot, l’entreprise peut par exemple intégrer ses données dans le Data Hub par domaine métier, le modèle de données sera construit de façon itérative pour intégrer les données de l’entreprise.

Stambia permet d’avoir une accessibilité et une lisibilité sur les flux du Data Hub à l’aide de l’architecture ELT (délégation des transformations au moteur de base de données). En effet les scripts de transformation de Stambia sont générés en langage natif de la base de données du Data Hub (SQL), l’accessibilité aux scripts générés permet d’éliminer l’effet de la boite noire.

De plus, Stambia stocke les données d’audit dans une base de données relationnelle, ce qui donne plus de flexibilité dans le choix de l’outil de Reporting qui servira pour mettre en place la plateforme d’audit.

Conclusion

Dans cet article, nous avons vu les grands axes d’un projet de mise en place d’un Data Hub : la définition des systèmes à interconnecter, l’acquisition des données, la création et l’alimentation du modèle de données, la propagation des données et le suivi du Data Hub via la plateforme d’audit.

Toutes ces étapes doivent être suppléées par un outil d’intégration de données comme Stambia, permettant d’apporter de l’agilité au projet et de gérer une multitude de technologies.